Продвижение: добавление сайта в поисковики, robots.txt

Грамотная и своевременная раскрутка - это очень хорошо и правильно. И ей обязательно надо заниматься. Но при этом следует четко понимать в какой именно момент её начинать и с чего.

Грамотная и своевременная раскрутка - это очень хорошо и правильно. И ей обязательно надо заниматься. Но при этом следует четко понимать в какой именно момент её начинать и с чего.Не буду попусту заниматься морализаторством и надеюсь у вас после вводной статьи в голове и нет таких мыслей, как и желания спустить деньги, время и усилия на раскрутку не вовремя.

Начинать раскрутку всегда стоит с анализа своего сайта и аудитории. Не всегда хорошая раскрутка - это оккупация поисковой выдачи. SEO - это всего лишь один из методов продвижения в интернете.

Самое простое и первое, с чего стоит начать в рамках SEO - это добавить сайт в поисковые машины для индексации. Это вовсе не значит, что завтра его проиндексируют, а послезавтра он появится в выдаче на первых позициях. Но сообщить им о сайте уже можно - индексация процесс не самый быстрый, а достижение топовых позиций в серпе (SERP - "search engine results page", страница поисковой выдачи) еще длительнее.

Поисковики обычно узнают о новинках в сети двумя способами - либо индексируя какой-то сайт, находят на нем ссылку на ваш ресурс и идут проверять, чего ж там такого появилось, либо вебмастер сам, при помощи специальных сервисов сигнализирует, что к нему надо зайти, проиндексировать.

Самый частый вопрос, касающийся раскрутки uCoz-сайтов, это карантин. Карантин - это запрет на индексацию сайта поисковыми ботами. В системе он составляет 30 дней с момента создания сайтов. Причин для его существования несколько: первая, это, то что с введением карантина на Юкозе перестали создавать в огромных количествах дорвеи - бессмысленные сайты направленные исключительно на SEO-цели. И вторая - это защита от преждевременной индексации пустого сайта: попав на пустой сайт, поисковик индексировал страницы, практически без контента и второй раз заходил на сайт очень-очень не скоро.

Для грамотного общения с поисковиками у каждого вашего сайта существует специальный файл robots.txt. Найти и посмотреть его можно по адресу:

http://вашсайт.ucoz.ru/robots.txt

В нем описываются правила для поисковых ботов (боты - это инструмент поисковой машины, при помощи которых она собирает информацию о страницах в сети). Подробно о директивах можно прочитать вот тут. Если кратко, то в нем описано какие страницы можно заносить в индекс (для последующей выдачи в результате поисковых запросов), а какие нельзя. "Почему это нельзя?!" - Можете возмутиться вы, - "Пусть будет весь мой сайт!" - И окажетесь не правы. На сайте присутствуют служебные страницы, например, такие как вход-выход, регистрация пользователей и если поисковик будет их запоминать, то может пропустить что-то ценное в свой приход. (Так как заходя на сайт поисковый паук может "уволочь" с собой в индекс только ограниченное кол-во страниц, а не весь сайт).

Robots по умолчанию разработан таким образом, что поисковикам скармливаются только страницы с осмысленным содержимым. И редактировать его не рекомендуется, особенно, если вы не особо понимаете, что делаете.

Для нового сайта robots.txt выглядит вот так:

User-agent: *

Disallow: /

По истечению карантина файл автоматически обновляется и можно начинать любые меры по раскрутке.

Выглядит он вот так (на примере robost.txt для этого блога, светло серым дана расшифровка каждой строчки):

User-agent: *

| Всем поисковым ботам

|

Прикрепленный домен не снимает карантина. Если вы уверены, что ваш сайт полностью готов, а прошло только, к примеру, 17 дней после создания - вы можете обратиться в службу поддержки - и если это действительно так, то карантин вам снимут. При оплате услуги, дороже $2 - robots.txt становится доступным для редактирования.

А теперь немного конкретных ссылок:

Для того чтобы добавить сайт в базу Яндекса (по сути, позвать его ботов исследовать ваш сайт) можно пойти по 2-м путям. Первый - простой. Ввести свой URL на странице:

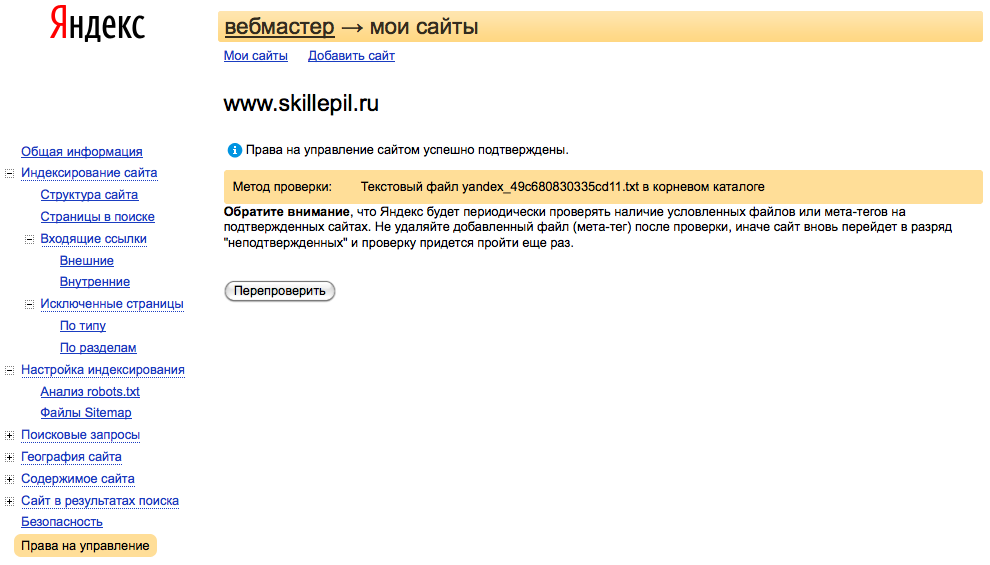

Второй посложнее, но рекомендую вам именно его. Это зарегистрироваться в сервисе Яндекс.Вебмастер и уже через него добавить сайт на индексацию.

В этом случае вы будете видеть статистику по страницам в индексе и указание на проблемы, если они вдруг возникнут. Так же этот сервис предоставит вам полную статистику (после нехитрой процедуры подтверждения прав на сайт) о точках входа-выхода, позициям в серче, поисковым словам, по которым к вам заходят и еще массу полезных сведений:

Аналогичные сервисы есть и у Google.

Для добавления своего сайта, воспользуйтесь вот этой страницей.

Так же полезно изучить инструментарий для вебмастеров, предоставляемый Google.

На этом самую первую статью о самых частых вопросах про поисковики предлагаю считать законченной, если что-то осталось непонятным - задавайте вопросы в комментариях.

В следующей статье будет рассказано про sitemap, про добавление частей сайта (блог, форум) в поиск по блогам и про правильную верстку для оптимизации для поисковых машин.

В следующей статье будет рассказано про sitemap, про добавление частей сайта (блог, форум) в поиск по блогам и про правильную верстку для оптимизации для поисковых машин.

76 комментариев

1 2 »

1-20 21-32

Ваш комментарий

обидно, да ...

обидно, да ...